📝 ملخص كورس علم البيانات - 14

الجزء الرابع من فصل التعلم غير الموجَّه يتحدث عن خوارزمية تحليل العنصر الأساسي PCA

الفصل الثالث - التعلم غير الموجَّه Unsupervised Learning

الدرس الرابع - Dimensionality Reduction and PCA

تستخدم PCA في التعلم غير الموجَّه لإكتشاف الأنماط Patterns. تقوم الخوارزمية بجمع البيانات ومحاولة إيجاد انماط فيما بينها، ثم جمع كل واحده في Cluster خاصة بها بجانب ما يشابهها.

الفيديو التالي يشرح طريقة عملها

Latent Features - Feature Selection

متغيرات ليست موجودة في البيانات الأصلية لدينا، لنقل أن لدينا بيانات منازل وفيها المتغيرات التالية:

- حجم الأرض

- عدد الغرف

- مساحة المنزل

- مساحة المخزن

- عدد غرف النوم

- عدد دورات المياة

- معدل الجرائم في الحي

- عدد المدارس في الحي

- الضرائب في الحي

- متوسط مصادر الدخل للجيران

- متوسط جودة الهواء

- المسافة إلى الخط السريع

في المتغيرات السابقة ممكن ان نستخرج متغيرين جدد غير الموجودة لدينا وهي لأول 6 متغيرات وآخر 6 متغيرات، المتغيرات الجدد هي حجم المنزل والثاني معلومات الحي. بذلك قللنا عدد المتغيرات لدينا في البيانات.

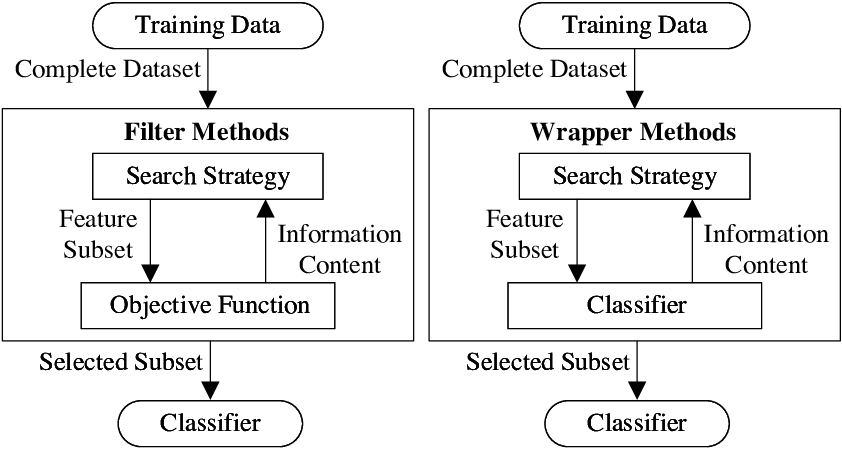

توجد عدة طرق لإختيار المتغيرات وهي: 1

- Filter methods: ومن مسماها ممكن ان نتوقع أنها تقوم بفلترة المتغيرات الموجودة وترتيبها حسب اهميتها لدينا، يتم بعد ذلك تقيمها بعدة طرق (تفاصيل أكثر عن هذه الطرق هنا) ثم إعتمادها.

- Wrapper Methods: هذة الطريقة تقوم بالتحقق من اهمية المتغير مباشرة مع المودل، اذا انتجت المودل افضل نتيجة له فسيتم إختيار تلك المتغيرات.

مثال بايثون

في الرابط التالي: هنا مثال عملي طويل ومفصل لطريقة عمل خوارزمية PCA.

متى نستخدم PCA

تستخدم الخوارزمية متى ما أردنا التقليل من عدد المتغيرات Features لدينا. في بعض الأحيان في الصور مثلاً، قللنا المتغيرات من 700 متغير إلى 30 متغير وحصلنا على نفس النتائج.

العودة إلى ملخص كورس علم البيانات - 13 - الإنتقال إلى ملخص كورس علم البيانات - 15

كُتب في 16/04/2019